스크래핑 툴 중 어느 것이 더 좋을까? 스크래핑 툴 10개 추천

빅데이터 기술의 급속한 발전과 진화는 데이터 수집에 대한 사람들의 수요를 점점 더 증가시켰습니다. 이로 인해 데이터 수집 제품에 대한 광범위한 시장 전망을 가져왔습니다. 최근 몇 년 동안 다양한 데이터 수집 제품이 국내외에서 등장했습니다. 오늘날 우리는 주로 다양한 데이터 수집 도구를 분석하여 더 적합한 데이터 수집 제품을 선택하는 데 도움이 될 것입니다.

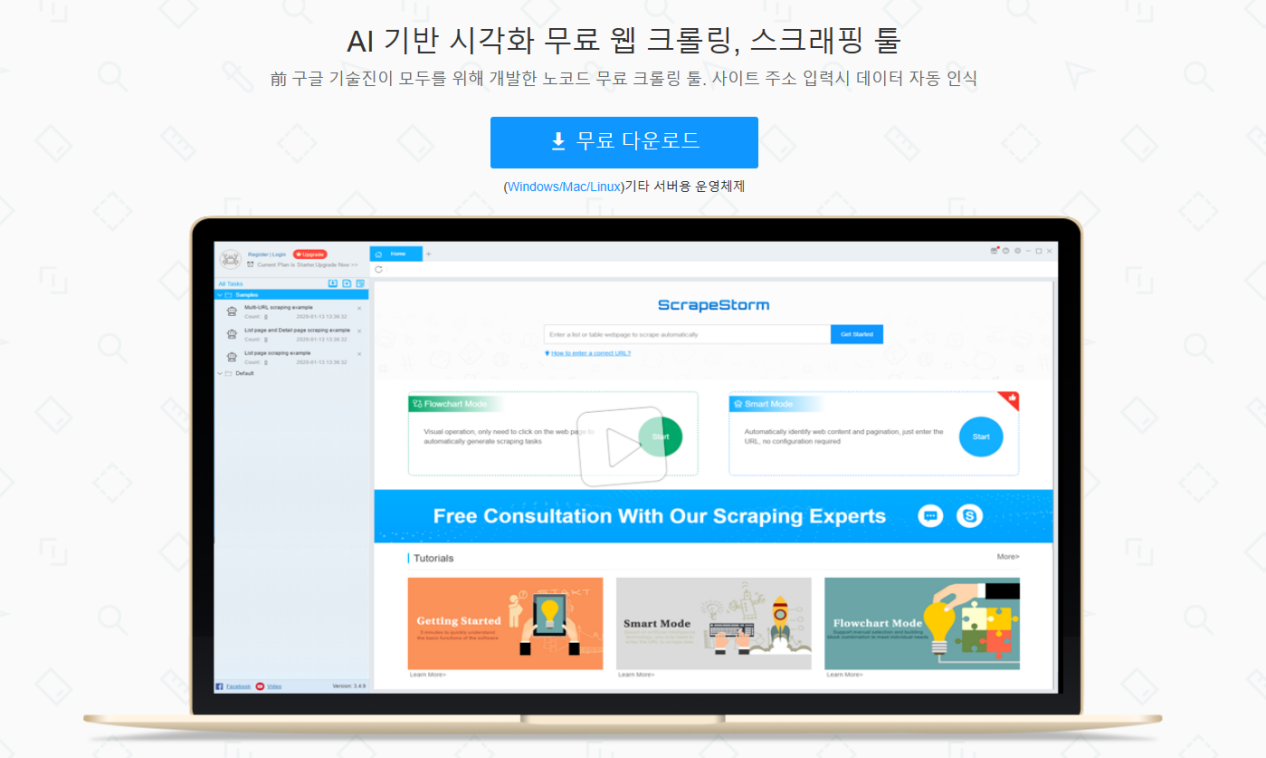

1. ScrapeStorm:https://kr.scrapestorm.com/

ScrapeStorm은 강력한 기능과 간단한 조작으로 프로그래밍되지 않은 대다수의 사용자를 위한 소프트웨어입니다. 인공지능 알고리즘을 기반으로 웹 주소를 입력하면 목록 데이터, 테이블 데이터 및 페이지 버튼을 지능적으로 식별할 수 있으며 수집 규칙을 구성할 필요가 없으며 원클릭으로 수집합니다. 수집 리스트, 표, 링크, 이미지, 가격 등 다양한 유형의 데이터를 식별할 수 있습니다. 데이터를 자동으로 수집할 수 있을 뿐만 아니라 수집 과정에서 데이터를 청소할 수도 있습니다. 정기적인 수집, 자동 내보내기, 파일 다운로드, 가속 엔진, 그룹별 부팅 및 내보내기 등 다양한 기능을 갖추고 있습니다.

수집된 결과는 TXT, EXCEL, CSV 및 HTML 파일 형식을 지원하거나 데이터베이스(MySQL, MongoDB, SQL Server, PostgreSQL)에 직접 게시할 수 있습니다. 동시에 Windows, Mac 및 Linux의 전체 운영 체제 수집 소프트웨어를 지원하며 플랫폼 버전이 완전히 동일하고 원활하게 전환됩니다.가장 중요한 것은 이 소프트웨어가 비용을 받지 않고 무제한 데이터를 무료로 내보낼 수 있다는 것입니다.

2. 리스틀리(Ristlet):https://www.listly.io

데이터 수집의 기본 요구 사항을 충족합니다.

단 엑셀로의 내보내기만 지원됩니다. 가격이 조금 비싸고 일부 기능은 월 9만 원짜리 유료 버전에서만 사용할 수 있습니다.

3. ParseHub:https://www.parsehub.com

ParseHub 앱을 바탕화면에 다운로드한 후 WebSanit에서 데이터를 추출하여 분석할 수 있습니다.

인터페이스는 직관적이지만 다른 페이지를 성공적으로 수집하기 위해서는 몇 가지 용어를 배워야 합니다.

4. 스파이더킴(Spider Kim):https://www.blog.spiderkim.com

지난 2018년 설립된 유펜솔루션은 간편한 조작만으로 양질의 데이터를 수집할 수 있는 서비스형 소프트웨어(SaaS) 솔루션 '스파이더킴'을 개발했다.

하지만 한 달에 50만원씩 내야 할 정도로 비쌉니다.

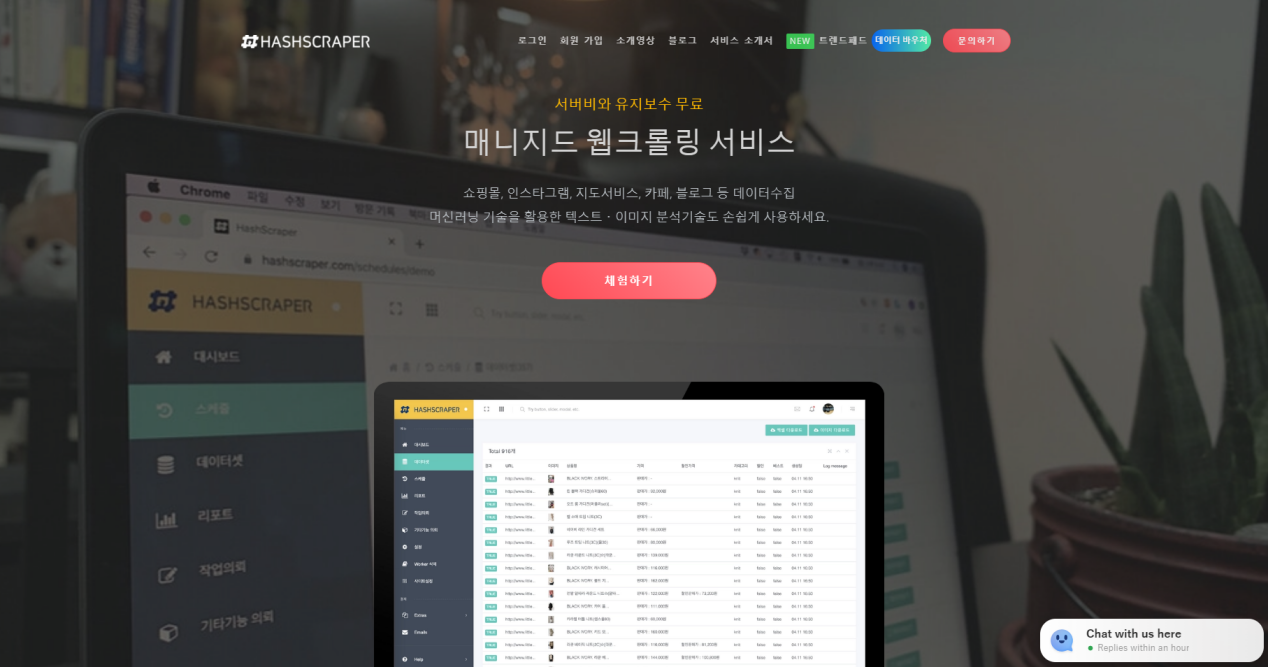

5. 해시스크래퍼(HashScrapher):https://www.hashscraper.com

해시스크래퍼는 데이터를 수집·분석하는 네트워크 수집 서비스를 제공하는 스타트업으로 네트워크 데이터 수집 솔루션을 제공합니다.

하지만 아직 해외는 아니고 국내에만 한정돼 있습니다.

6. 웹 크롤링(Web Crawling): 공식 웹사이트 없음

삼성생명이 자체 개발한 '웹크롤링' 기술은 보험사기 적발에 활용됩니다.

다만 보험사기 분야에 한정돼 있어 적용 범위가 다소 좁습니다.

7. Import.io:https://www.import.io

웹 검색기라고도 하며 사이트를 테이블로 변환할 수 있습니다.더 복잡한 웹 사이트를 캡처해야 하는 경우 사용자는 데스크톱 응용 프로그램을 다운로드해야 합니다. 더 크거나 복잡한 데이터 추출을 원하는 기업에게 엔터프라이즈급 유료 옵션도 제공합니다.

그러나 일부 복잡한 웹 페이지 구조에 대한 처리 능력은 상대적으로 취약합니다.

8. Visual Web Ripper:https://refinepro.com/toolbox/visual_web_ripper/

다양한 기능을 지원하는 자동화된 웹 캡처 도구입니다.

그러나 수집이 어려운 일부 고급 웹 페이지 구조에 적합하며 사용자는 강력한 프로그래밍 기술이 필요합니다. 또한 클라우드 수집 서비스를 제공하지 않아 수집 효율이 제한될 수 있습니다.

9. Content Grabber:https://www.contentgrabber.com

많은 강력한 스크립트 편집, 디버깅 인터페이스를 제공합니다. 사용자는 내장된 도구를 사용하는 대신 정규 표현식을 작성할 수 있습니다.

그러나 사용자에게 기본 기능을 완전히 제공하지 않으며 고급 프로그래밍 기술을 가진 사람들에게 적합합니다.

10. Mozenda:https://www.mozenda.com

데이터 클라우드 백업 기능을 포함하여 사용자에게 많은 실용적인 기능을 제공하는 클라우드 기반 데이터 수집 소프트웨어입니다.

그러나 불규칙한 데이터 구조(예: 목록, 표)는 다루기 어렵고 복잡한 웹 페이지 구조, 소프트웨어 조작 인터페이스 도약, 사용자 경험이 충분하지 않아 기본 크롤러 경험이 있는 사람들에게 적합합니다.

만약 여러분이 기초가 없고, 쉽고 손쉬운 것을 좋아한다면, 개인적으로 가장 추천하는 것은 역시 ScrapeStorm으로 데이터 수집의 "자유"를 쉽게 실현하는 것입니다!

자, 오늘의 나눔을 보고 여러분이 스크래핑 툴을 고르는 데 도움이 될 수 있기를 바랍니다!